Les tensors : la matrice évoluée

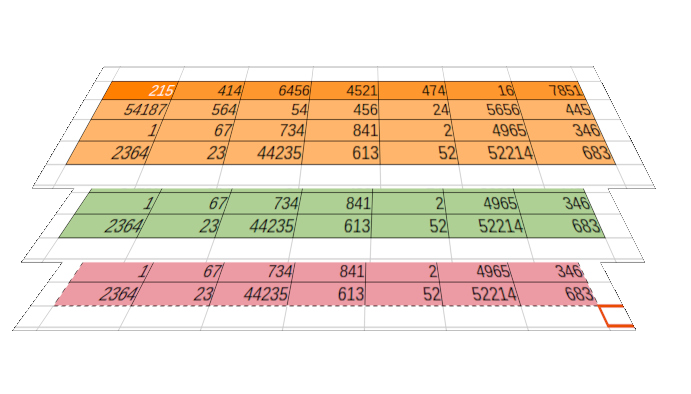

Pour comprendre les LLM, il faut d'abord comprendre les tenseurs. Imaginez une feuille de calcul Excel :

- Une cellule unique contient un nombre (dimension 0)

- Une ligne de cellules forme un vecteur (dimension 1)

- Un tableau forme une matrice (dimension 2)

- Un tensor, c'est comme empiler plusieurs tableaux (dimension 3 et plus)

Les tenseurs permettent de représenter des données complexes de manière structurée, comme les mots, les images, ou les sons.

L'embedding : donner du sens aux mots

L'embedding est une technique qui transforme les mots en nombres. Mais pas n'importe comment ! Les mots similaires se retrouvent proches dans l'espace mathématique. Par exemple :

- "roi" - "homme" + "femme" ≈ "reine"

- "Paris" est plus proche de "Londres" que de "banane"

C'est comme créer une carte où chaque mot a des coordonnées qui reflètent son sens et ses relations avec les autres mots.

Les Transformers : l'architecture révolutionnaire

En 2017, Google présente les Transformers dans leur article "Attention is all you need". Cette architecture révolutionne le traitement du langage grâce à deux innovations majeures :

-

Le mécanisme d'attention :

- Permet à l'IA de "se concentrer" sur les parties importantes d'une phrase

- Peut traiter plusieurs éléments en parallèle

- Comprend le contexte beaucoup mieux que les systèmes précédents

-

L'architecture encodeur-décodeur :

- L'encodeur analyse le texte d'entrée

- Le décodeur génère la réponse

- Les deux communiquent via le mécanisme d'attention

Des Transformers aux LLM

Les Large Language Models (LLM) comme GPT sont des Transformers géants qui ont été entraînés sur d'énormes quantités de textes. Leur évolution est impressionnante :

- BERT (2018) : Comprend le contexte dans les deux sens

- GPT (2018) : Génère du texte cohérent

- GPT-2 (2019) : Améliore la génération

- GPT-3 (2020) : Introduit l'apprentissage "few-shot"

- GPT-4 (2023) : Multimodal et encore plus performant

À suivre dans la dernière partie : Comment fonctionne concrètement un LLM...